[간단 내용 정리]

[논문 본문 번역본]

[Abstract]

프롬프트 엔지니어링은 다양한 애플리케이션에서 대규모 언어 모델(LLM)의 기능을 활용하는 데 매우 중요합니다. 기존의 프롬프트 최적화 방법은 신속한 효과를 개선하지만, 새로 생성된 프롬프트는 이전에 성공한 사례에 악영향을 미치면서 실패를 해결하는 경우가 많습니다. 또한 이러한 방법은 신속한 최적화 작업을 위해 LLM의 고유한 기능에 크게 의존하는 경향이 있습니다. 본 논문에서는 최적화 목표를 달성하기 위한 중요한 요소를 식별하기 위해 성공한 사례와 실패한 사례의 인사이트를 활용하여 신속한 표류를 완화하도록 설계된 새로운 접근 방식인 STRAGO(전략적 유도 최적화)를 소개합니다. STRAGO는 컨텍스트 학습을 통합하여 신속한 최적화를 위한 세부적이고 단계별 지침을 제공하는 실행 가능한 구체적인 전략을 공식화하는 방법론을 사용합니다. 추론, 자연어 이해, 도메인별 지식, 산업용 애플리케이션을 포함한 다양한 작업에 걸쳐 수행된 광범위한 실험은 STRAGO의 우수한 성능을 입증합니다. 이는 신속한 최적화에서 새로운 최첨단 기술을 확립하여 안정적이고 효과적인 신속한 개선을 제공하는 능력을 보여줍니다.

[1. Introduction]

최근 ChatGPT 및 GPT-4와 같은 대형 언어 모델(LLM)의 발전으로 분석, 추론 및 맥락 이해 기능이 크게 향상되었습니다(Yue et al., 2024; Chang et al., 2023; Xu et al., 2024). LLM은 사용자가 프롬프트를 통해 모델과 상호 작용하는 Microsoft Copilot 및 New Bing과 같은 다양한 애플리케이션에 사용됩니다. 이러한 프롬프트는 LLM의 응답을 안내하고 결과가 정확하고 관련성이 높으며 유용한지 확인하는 데 중요한 역할을 합니다. 그러나 LLM의 성능은 프롬프트 품질에 크게 의존하며 효과적인 크래프팅 프롬프트는 여전히 상당한 전문 지식이 필요한 복잡하고 노동 집약적인 작업입니다.

효과적인 프롬프트 제작의 어려움을 극복하기 위해 최근 연구는 프롬프트를 자동으로 생성하고 최적화하는 데 초점을 맞추고 있습니다. 초기 접근 방식은 강화 학습(Deng 외, 2022) 또는 기울기 기반 방법(Shin 외, 2020)을 활용했지만, 이러한 기술은 종종 추가 교육이 필요하거나 모델의 내부 상태에 따라 달라져 ChatGPT 및 GPT-4와 같은 API 기반 LLM에 대한 적용 가능성이 제한됩니다. 최근 연구에서는 LLM 자체를 프롬프트 생성기(Zhou et al., 2022) 또는 최적화기(Yang et al., 2023)로 활용하고 있습니다. 몬테카를로 트리 검색(MCTS)(왕 외, 2023)과 같은 고급 검색 알고리즘(Guo et al., 2023; 페르난도 외, 2023)도 효과적인 프롬프트를 발견하기 위해 적용되었습니다. 또한 일부 연구에서는 LLM의 반사 기능을 활용하여 잘못된 예제를 사용하여 명시적 또는 암묵적으로 개선을 안내함으로써 프롬프트를 최적화했습니다(Pryzant 외, 2023; Yang et al., 2023; Hu et al., 2023; Tang et al., 2024). 이러한 LLM 기반 최적화 방법은 다양한 작업에서 효과를 입증했으며 프롬프트 품질을 개선할 수 있는 가능성이 있습니다.

그러나 검색 기반 알고리즘은 각 단계에서 명확한 최적화 방향이 없기 때문에 신속한 최적화에서 비효율성을 겪는 경우가 많습니다. 성찰 지향적 방법은 잘못된 사례를 반복적으로 분석하고 수정하는 데 집중하여 수렴을 가속화하는 것을 목표로 합니다. 그러나 실패 사례에 집중하면 특히 오류가 이상값 특성을 나타낼 때 올바른 사례에 부정적인 영향을 미칠 수 있습니다. 검색 기반 접근 방식과 성찰 지향 접근 방식 모두 새로 생성된 프롬프트가 특정 실패를 해결하지만 이전에 성공한 사례를 의도치 않게 방해하는 프롬프트 드리프트를 초래할 수 있습니다.

또한 이러한 방법은 일반적으로 원하는 결과를 달성하는 방법에 대한 구체적인 지침을 제공하지 않고 LLM의 고유한 기능에만 의존하면서 작업 설명과 컨텍스트를 제공합니다. 예를 들어, OPRO(Yang et al., 2023)는 해당 점수와 작업별 데이터가 포함된 과거 프롬프트를 제공하므로 LLM이 더 효과적인 프롬프트를 생성할 것으로 예상합니다.

EvoPrompt(Guo et al., 2023)는 LLM에 두 개의 프롬프트를 지침이나 전략 없이 새 프롬프트로 병합할 것을 요청합니다. 마찬가지로 APO(Pryzant et al., 2023)는 잘못된 사례를 제시하고 LLM에 새로운 프롬프트로 수정할 것을 요청하지만 실행 가능한 지침은 제공하지 않습니다. LLM의 고유한 능력에 대한 이러한 과도한 의존성은 복잡한 작업에서 문제가 될 수 있으며, 모델에 필요한 기술이 부족하여 최적의 프롬프트 생성이 아닐 수 있기 때문입니다.

본 논문에서는 기존 접근 방식의 한계를 극복하기 위해 설계된 새로운 성찰 기반 신속 최적화 방법인 STRAGO(전략적 가이드 최적화)를 소개합니다. 이전 방법과 달리 STRAGO는 각 반복에서 성공한 결과와 실패한 결과를 모두 분석하고, 작업 성공에 필요한 주요 요인을 식별하고, 실패 원인을 이해함으로써 실패 사례에 대한 편견을 피합니다. 이 분석을 사용하여 STRAGO는 컨텍스트 내 학습을 사용하여 신속한 개선을 위한 세부적인 단계별 지침을 제공하는 실행 가능한 구체적인 전략을 개발합니다. 이러한 전략은 분석 결과와 결합하여 프롬프트를 최적화하는 데 사용됩니다. 추론, 자연어 이해, 도메인 지식 및 산업 응용 분야에 걸친 광범위한 실험을 통해 이 접근 방식이 성공 사례에 대한 부작용을 최소화하면서 실패를 효과적으로 수정한다는 것을 입증했습니다.

이 편향되지 않은 반복 프로세스는 자세한 지침과 함께 최적화 후 최고의 전반적인 정확도 향상을 달성하여 신속한 최적화에 새로운 최첨단 기술을 구축합니다.

우리의 주요 기여는 다음과 같습니다:

1. 편향되지 않은 반사 최적화: STRAGO는 최적화 프로세스에 성공 사례와 실패 사례를 모두 통합하여 신속한 드리프트를 완화하여 보다 안정적이고 신뢰할 수 있는 신속한 개선을 달성합니다.

2. 실행 가능한 전략 개발: STRAGO는 컨텍스트 내 학습을 활용하여 신속한 최적화를 안내하는 단계별 실행 가능한 전략을 수립하여 초기에 충분한 전문성이 부족한 작업에서 LLM의 잠재력을 발휘합니다.

3. 다양한 작업에 걸친 광범위한 검증: 추론, 언어 이해, 도메인별 지식, 산업 애플리케이션 등 다양한 작업에 걸쳐 STRAGO를 광범위하게 평가하여 STRAGO가 신속한 최적화에서 최첨단 성능을 달성한다는 것을 입증합니다.

[2. Methodology]

[2.1 Preliminaries]

[2.1.1 Task Formulation]

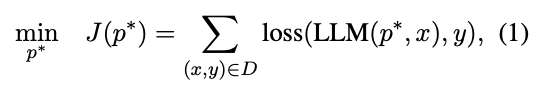

작업 데이터 세트 D가 주어졌을 때, 우리의 목표는 LLM이 원하는 출력과 밀접하게 일치하는 응답을 생성할 수 있는 최적의 프롬프트 p ∗를 찾는 것입니다.

이 문제는 다음과 같이 공식화할 수 있습니다:

여기서 x와 y는 작업 데이터 세트 D의 입력과 해당 원하는 출력을 나타내며, p ∗는 D의 모든 입력-출력 쌍에 대한 LLM의 출력과 원하는 출력 사이의 손실을 최소화하는 최적의 프롬프트입니다.

[2.1.2 Assessment Metrics]

정확도는 LLM을 사용하여 작업을 해결할 때 프롬프트의 효과를 평가하는 주요 지표입니다. 그러나 반복적인 프롬프트 최적화 과정에서 새로운 프롬프트가 이전에 성공한 사례와 실패한 사례 모두에 어떤 영향을 미치는지 평가하는 것도 마찬가지로 중요합니다. 이를 포착하기 위해 두 가지 추가 지표를 소개합니다: 불리한 수정률(ACR)과 유익한 수정률(BCR):

여기서 ppre(xi)와 ppost(xi)는 각각 각 입력 xi와 그 기저 진리 yi에 대한 최적화 전후 모델의 예측을 나타냅니다.

ACR은 프롬프트를 적용한 후 부정확해지는 정확한 예측의 비율을 캡처하여 최적화의 부정적인 영향을 측정합니다. 반면, BCR은 이전에 수정된 잘못된 예측의 비율을 측정하여 긍정적인 영향을 정량화합니다. 이러한 지표는 정확성과 함께 새로운 프롬프트의 전반적인 효과를 종합적으로 평가하여 잠재적인 단점과 개선 사항을 모두 강조합니다.

[2.2 StraGo]

각 최적화 반복에서 STRAGO는 성공 사례와 실패 사례를 모두 샘플링하여 작업 목표를 달성하기 위한 주요 요인을 식별하고 현재 프롬프트가 LLM의 성공 또는 실패로 이어지는 이유를 이해합니다(Analyzer). 이 분석을 기반으로 최적화(Refiner)에 대한 자세한 단계별 지침을 제공하는 실행 가능한 전략을 생성합니다. 그런 다음 이러한 전략을 분석 결과와 결합하여 프롬프트를 최적화합니다(Optimizer). 그림 1은 TREC 작업(Voorhees and Tice, 2000)을 예로 들어 STRAGO의 세 가지 주요 단계를 보여줍니다. 각 모듈은 다음 하위 섹션에서 자세히 설명합니다. STRAGO에서 사용되는 모든 메타 프롬프트는 부록 D에 나와 있습니다.

[2.2.1 Analyzer]

STRAGO는 올바른 예제와 잘못된 예제의 분석에 동일한 우선순위를 부여함으로써 이전의 성찰 기반 방법과 차별화됩니다. 데이터 세트 D = (x1, y1), (x2, y2), . . (xn, yn)가 주어지면 모델은 평가 후 이를 두 개의 하위 집합으로 분할합니다: 올바르게 예측된 샘플의 경우 Dcorrect, 잘못 예측된 샘플의 경우 Dincorrect. 각 하위 집합에서 심층 분석을 위해 K개의 예제가 선택됩니다. 분석기는 이러한 선택된 예제를 검토하여 Dcorrect의 성공 요인과 Dincorrect의 실패 이유를 밝혀냅니다.

긍정적 경험과 부정적 경험이라고 하는 이러한 인사이트는 취해야 할 주요 조치와 피해야 할 일반적인 오류를 강조하여 LLM을 안내합니다.

구현에서 각 예제는 Dcorrect 또는 Dincorrect에 속하는지 여부에 따라 M개의 긍정적 또는 부정적 경험을 생성합니다.

[2.2.2 Refiner]

인지 과학 원리(Swanborn, 2010)에 따르면, 인간은 일반적으로 식별(무엇인지), 인과관계(왜 그런지), 방법(방법)의 세 가지 차원을 통해 문제 해결에 접근합니다. 이러한 맥락에서 경험은 식별 차원과 관련이 있습니다. LLM은 일반적으로 간단한 작업을 처리할 수 있지만, 그림 1(a)에 나와 있는 것처럼 특정 컨텍스트나 도메인 지식이 필요한 더 복잡한 문제로 어려움을 겪을 수 있으며, 프롬프트에 특정 컨텍스트나 주제가 부족합니다. 이러한 경우 LLM 성능을 개선하기 위해 리파이너는 전략 수립과 전략 선택이라는 두 단계 프로세스를 채택합니다.

[Strategy formulation]

Ma et al.(2024)이 언급한 바와 같이, LLM에서 생성된 오류는 특정 패턴을 따르는 경향이 있습니다. 예를 들어, 계산 오류는 수학 과제에서 흔히 발생하는 반면, 언어 과제에서는 오해나 문맥 이해 부족이 빈번하게 발생하는 문제입니다. 이러한 패턴에는 맞춤형 전략이 필요하므로 컨텍스트 내 학습 데모에 이상적입니다. 우리는 수학 과제의 계산 오류, 언어 과제의 오해, 추론 과제의 논리적 추론 오류 등 세 가지 일반적인 오류 유형에 초점을 맞춥니다. 우리는 각 오류 유형에 해당하는 전략을 개발하고 이를 컨텍스트 내 학습 데모로 사용하여 LLM이 긍정적인 경험과 부정적인 경험을 모두 기반으로 프롬프트를 개선하는 전략을 생성하는 데 도움을 줍니다.

앞서 언급한 각 오류 유형에 대해 하나 이상의 대표적인 예제를 선택합니다. LLM은 먼저 각 예제에 대한 경험을 생성하고 이를 해결하기 위해 구체적이고 실행 가능한 전략을 제안한 다음 수동 수정을 통해 개선합니다.

이러한 예제는 관련 경험 및 전략과 함께 context 내 학습 데모 역할을 하며, LLM이 성공 사례(긍정적 경험)와 실패 사례(부정적 경험)에 대한 세부적인 단계별 실행 계획을 공식화하는 데 도움이 됩니다. 구현에서 우리는 각 예제의 경험을 기반으로 각 예제에 대해 N개의 전략을 생성합니다. 그림 1(b)는 실패한 예제의 부정적인 경험을 해결하기 위해 N = 3에 대해 리파이너가 생성한 세 가지 전략을 보여줍니다.

[Strategy selection]

각 예제와 해당 경험에 대해 Refiner에서 생성한 N개의 전략에 대해 LLM을 사용하여 정렬, 명확성, 실현 가능성과 같은 기준을 기반으로 평가하고 점수를 매깁니다. 그런 다음 가장 높은 점수를 받은 전략이 선택되어 경험을 해결합니다.

우리는 여러 차원에 걸쳐 전략을 평가합니다: 전략이 식별된 문제를 얼마나 잘 해결하는지 평가하는 경험과의 일치, 전략이 명확하고 세부적인지 여부를 결정하는 전략의 명확성, 전략이 문제를 효율적으로 해결할 가능성을 측정하는 문제 해결의 효과. 평가 중 잠재적 자기 강화 편향을 완화하기 위해(Zheng et al., 2024), 우리는 채점에 다른 LLM(Claude)을 사용합니다. 또한 Thomas et al. (2023)에서 사용한 채점 방법에 따라 안정성과 신뢰성 향상을 위해 LLM으로 5회 평가를 수행하고 점수를 평균합니다. 그림 1(b)은 실패한 사례에서 부정적인 경험을 처리하는 세 가지 전략 각각에 대한 평균 점수를 제시하며, 가장 높은 점수를 받은 전략(가운데 표시)이 선택되었습니다.

[2.3 Optimizer]

LLM은 긴 텍스트 입력을 처리할 수 있지만, 긍정적인 경험과 부정적인 경험을 모두 처리할 때 관련 전략과 함께 모든 세부 사항을 철저히 고려하는 데 어려움을 겪는 경우가 많습니다. 이 문제를 완화하기 위해 이러한 경험을 별도로 처리한 다음 크로스오버 절차를 통해 결합하는 최적화 방법을 구현합니다. 옵티마이저는 세 가지 주요 단계로 작동합니다: 최적화, 크로스오버, 파라프레이즈.

[optimieze]

분석기는 선택한 성공 또는 실패한 각 예제에 대해 M개의 긍정적인 경험 또는 부정적인 경험을 생성합니다. 그런 다음 리파이너는 각 경험에 대한 전략을 생성하고 옵티마이저는 전략에 따라 수정된 프롬프트를 생성합니다. 이러한 수정된 프롬프트는 긍정적인 경험에서 파생된 프롬프트와 부정적인 경험에 기반한 프롬프트의 두 세트로 나뉩니다.

[Crossover]

LLM과 진화 알고리즘을 결합하면 신속한 융합을 개선할 수 있음을 보여주는 Guo et al. (2023)의 접근 방식에 따라 각 세트에서 하나씩 두 개의 프롬프트를 선택하고 크로스오버 연산을 수행하여 하이브리드 프롬프트를 생성합니다.

[Paraphrase]

캐시는 상위 n개의 프롬프트와 이전 평가의 해당 점수를 유효성 검사 세트에 저장하도록 유지됩니다. 각 하이브리드 프롬프트는 캐시의 프롬프트를 사용하여 구문 분석되며, 구문 분석된 프롬프트와 하이브리드 프롬프트는 모두 후보 프롬프트로 평가됩니다. 최적의 프롬프트는 정지 조건이 충족되지 않은 경우 다음 최적화 반복을 위해 선택되거나 최적화된 프롬프트로 출력됩니다. 그런 다음 캐시는 평가 결과와 함께 업데이트됩니다.

[3. Experiments]

[3.1 Evaluation Tasks]

우리는 BBH(Suzgun et al., 2022)에서 역사적으로 낮은 성과 점수로 선정된 비교적 어려운 과제 5가지를 선정했지만, 이는 평가에 포함된 간단한 과제 중 하나입니다.

이러한 작업 외에도 잘 알려진 두 가지 자연어 이해(NLU) 작업을 통합했습니다: 영화 리뷰를 기반으로 한 감정 분류 작업인 SST-5(Soher et al., 2013)와 반응 유형을 식별하는 TREC(Voorhees and Tice, 2000). 또한 MedQA(Jin et al., 2021)와 MedMCQA(Pal et al., 2022)를 포함하여 의학 및 약리학 지식과 관련된 작업에서 우리 방법의 효과를 평가합니다.

산업 시나리오에서 우리 방법의 효과를 평가하기 위해 개인화된 의도 쿼리라는 내부 개인화된 검색 작업을 선택합니다.

이 작업은 익명화된 검색 데이터를 사용하여 위치, 언어, 검색 기록과 같은 사용자별 정보를 기반으로 비개인화된 검색 결과의 순서를 변경해야 하는지 여부를 결정합니다. 이 작업에는 복잡한 산업 작업과 중복 정보가 포함된 다양하고 광범위한 데이터 콘텐츠의 전형적인 초기 프롬프트가 단계별로 포함됩니다. 이러한 특성은 산업 수준의 프롬프트 최적화에서 흔히 발생하는 과제입니다.

자세한 데이터 사양은 부록 A.1을 참조하시기 바랍니다.

[3.2 Baselines]

다음과 같은 신속한 최적화 방법은 우리의 방법과 비교하기 위한 기준선 역할을 합니다:

• CoT: CoT(Wei et al., 2022; Kojima et al., 2022)는 많은 연구에서 인기 있는 기준선입니다.

설정에서 CoT는 예제를 활용하지 않고 질문 뒤에 "단계별로 생각해 봅시다."라는 문구를 추가하여 시작됩니다.

• APO: APO(Pryzant et al., 2023)는 잘못된 예제에서 자연어 수준의 그래디언트를 생성하고 이러한 그래디언트를 사용하여 프롬프트를 역편집합니다. APO는 명시적인 피드백 방법을 나타냅니다.

• OPRO: OPRO(Yang et al., 2023)는 이전 프롬프트의 과거 궤적과 관련 점수를 추적하여 암묵적 피드백을 활용합니다. 프롬프트 최적화 과정에서 OPRO는 이러한 궤적을 활용하여 LLM이 더 높은 점수를 달성하기 위한 프롬프트를 생성하도록 안내합니다.

• EvoPrompt: EvoPrompt(Guo et al., 2023)는 유전 알고리즘 및 미분 진화와 같은 진화 알고리즘을 적용하여 검증 세트의 성능을 최적화하는 프롬프트를 생성합니다. 이는 검색 기반 최적화 기술을 위한 대표적인 방법입니다.

[3.3 Experimental Datails]

우리는 GPT4(Achiam et al., 2023)를 사용하여 광범위한 실험을 수행하여 스트라고의 효과와 기본 방법을 평가합니다. APO, OPRO, 스트라고는 모두 동일한 초기 프롬프트로 시작하며, EvoPrompt는 14가지 추가 변형을 사용합니다.

테스트 세트의 하위 집합이 프롬프트 최적화를 위한 검증 세트로 선택됩니다. 각 반복에서 검증 세트는 프롬프트 품질을 평가하는 데 사용됩니다. 최종 테스트 단계에서 나머지 테스트 샘플은 최적화된 프롬프트를 평가하는 데 사용됩니다. 각 방법에 대해 검증 점수가 가장 높은 상위 5개의 최적화된 프롬프트를 선택하고 테스트 샘플에 대해 평가하여 가장 성능이 좋은 프롬프트의 성능을 보고합니다. 스트라고의 경우 K, M, N을 3으로 설정합니다. 일관된 평가를 위해 온도를 0으로 설정합니다.

Ma 등(2024)이 요약한 바와 같이, 모든 방법은 거의 동일한 수의 프롬프트 검색을 수행합니다. 자세한 매개변수 설정은 부록 A.3에 나와 있습니다.

[3.4 Main Results]

실험 결과는 표 1에 보고되어 있으며, STRAGO는 6가지 작업에서 모든 기준선을 지속적으로 능가하여 접근 방식의 효과를 보여줍니다.

BBH 및 NLU 작업에 대한 성능.

STRAGO는 BBH에서 79.77%, SST-5에서 56.34%, TREC에서 87.21%의 정확도를 달성하여 이전의 최첨단(SOTA) 방법을 각각 2.37%, 0.82%, 2.31% 초과 달성했습니다. 이러한 결과는 비교적 간단한 작업에서 STRAGO의 강력한 성능을 보여줍니다. 반면, EvoPrompt는 BBH 및 TREC에서 APO 및 OPRO보다 작은 개선 사항을 보여주며, 이는 EvoPrompt와 같은 검색 기반 방법이 빠른 수렴에서 어려움에 직면할 수 있음을 시사합니다. 이는 반복적인 프롬프트 최적화에서 빠른 수렴을 위한 정확하고 표적화된 최적화 전략의 중요성을 강조합니다.

도메인별 작업의 성능. 주목할 만한 추세는 MedQA 및 MedMCQA와 같은 도메인별 작업에서 모든 기준선이 제한된 개선 사항을 보이며 1%를 초과하지 않는다는 것입니다. 일부 방법, 특히 EvoPrompt는 데이터의 피드백을 활용하지 못하기 때문에 성능 저하를 보이기도 합니다. 도메인별 작업에서 LLM의 고유한 기능에만 의존하면 데이터의 특성에 잘 맞는 프롬프트를 생성하지 못하는 경우가 많습니다. 반면, STRAGO는 MedQA에서 1.22%, MedMCQA에서 1.33%의 향상을 보이며 개선된 것으로 나타났습니다. 이는 STRAGO의 단계별 프롬프트 수정 전략이 관련 도메인 지식을 유도하고 이러한 작업에 필요한 특정 전문 지식에 맞는 프롬프트를 생성하는 데 더 효과적임을 시사합니다.

산업 시나리오 작업의 성능.

개인화된 의도 쿼리 작업에서는 데이터의 고유한 특성으로 인해 STRAGO와 APO만 비교합니다. 표 1과 같이 APO는 단계별 지침을 처리할 때 성능 저하를 경험하는데, 이는 긴 방향으로 편집이 필요한 특정 단계를 정확하게 식별하는 데 어려움을 겪기 때문일 수 있습니다. 반면, STRAGO는 2.16%의 성능 향상을 달성하여 단계별 전략을 수립하면서 점진적으로 경험을 통합하는 접근 방식이 최적화를 위한 귀중한 컨텍스트 정보를 제공한다는 것을 보여줍니다.

요약하면, 스트라고는 단순한 프롬프트뿐만 아니라 산업 시나리오에서 발생하는 작업을 포함한 복잡한 작업을 처리하는 데에도 효과적입니다.

[4. Analysis]

[4.1 Data Analysis]

신속한 최적화 과정에서 잘못된 예측 샘플을 수정하면서 정확하게 예측된 샘플을 유지하는 것의 중요성을 검증하기 위해 각 최적화 방법의 신속한 드리프트 효과를 분석합니다.

구체적으로, 다양한 방법으로 생성된 최종 프롬프트와 초기 프롬프트를 비교하여 최적화된 프롬프트가 기존 오류를 수정하는 동안 얼마나 많은 새로운 오류를 발생시키는지 평가합니다. 결과는 표 2에 보고되어 있습니다.

표 2에서 볼 수 있듯이 STRAGO는 6개의 작업 중 4개 작업에서 가장 낮은 ACR과 가장 높은 BCR을 보이며, 이는 최적화된 프롬프트가 더 많은 잘못된 샘플을 수정하는 동시에 기본 방법보다 더 적은 수의 정확한 예측 샘플에 악영향을 미친다는 것을 나타냅니다. 이는 베이스라인과 비교하여 STRAGO의 우수한 성능을 보여줍니다. 정확도가 높은 초기 프롬프트가 있는 작업에서 올바른 샘플을 유지하는 것의 영향이 특히 중요합니다. 예를 들어, 정확도가 77.83%인 MedQA의 경우 APO가 STRAGO보다 더 많은 오류를 수정하지만(26.92% 또는 70개의 잘못된 샘플에 비해 34.62% 또는 90개의 잘못된 샘플), 더 많은 정확한 샘플에도 악영향을 미칩니다(4.49% 또는 41개의 올바른 샘플에 비해 10.41% 또는 95개의 올바른 샘플). 이로 인해 표 1과 같이 STRAGO에 비해 APO의 성능이 저하됩니다. 이는 STRAGO가 프롬프트 최적화 중에 올바른 예제와 긍정적인 경험을 통합하여 전체 작업 목표에서 크게 벗어나지 않기 때문이며, 특히 초기 프롬프트가 이미 효과적인 경우 더욱 그렇습니다.

[4.2 Ablation Study]

우리는 쉽게 최적화할 수 있는 TREC 작업과 도메인 지식 집약적인 MedMCQA 작업의 두 가지 작업에 대해 심층 분석을 수행합니다. 이 연구에서는 분석기에서 긍정적인 경험과 부정적인 경험을 모두 체계적으로 제거하고 정제기에서 전략을 제거합니다. 실험 결과는 표 3에 나와 있습니다.

경험의 영향.

표 3의 결과에 따르면 긍정적인 경험을 제거하면 ACR이 크게 증가하여 두 작업 모두에서 STRAGO의 성능이 저하되는 것으로 나타났습니다.

이는 정확하게 예측된 샘플을 유지하고 전반적인 작업 성능을 향상시키는 데 있어 긍정적인 경험의 중요한 역할을 강조합니다. 또한 표 1과 비교한 결과, 긍정적인 경험과 전략만 활용할 때 STRAGO가 성능을 효과적으로 최적화하여 TREC 작업의 모든 기본 방법을 지속적으로 능가할 수 있는 것으로 나타났습니다. 반대로 부정적인 경험을 제거하면 BCR이 감소하여 이러한 경험이 잘못된 샘플을 수정하고 잘못된 예측 데이터의 하위 집합에 적응하는 데 중요한 정보를 제공한다는 것을 알 수 있습니다. 이러한 경험이 없으면 프롬프트를 효과적으로 수정할 수 있는 옵티마이저의 능력이 저하되어 이 데이터 하위 집합과 관련된 중추적인 텍스트의 통합을 방해합니다.

전략의 영향.

표 3을 분석한 결과, 스트라고는 명시적인 전략 없이도 간단한 작업에서도 강력한 성능을 유지하는 것으로 나타났습니다.

그러나 전략이 누락되면 도메인 지식이 필요한 작업에서 STRAGO의 효과가 크게 감소합니다. 이러한 격차는 간단한 작업에서는 LLM이 고유한 기능을 활용하여 신속한 최적화를 위해 유용한 지식을 추출할 수 있다는 사실에서 발생할 수 있습니다. 반면에 이러한 기능은 지식 집약적인 작업에는 종종 불충분합니다. 명시적인 실행 전략을 통합함으로써 STRAGO는 더 심층적인 분석 사고에 참여하고 더 많은 도메인별 인사이트를 발견하며 옵티마이저에 대한 귀중한 지침을 제공하는 LLM의 능력을 향상시킵니다.

[4.3 Convergence Analysis]

우리는 그림 2에 표시된 결과와 함께 TREC 작업의 세 가지 기본 방법과 비교하여 STRAGO의 수렴을 분석합니다. 특히 STRAGO는 기본 방법보다 훨씬 빠르게 수렴합니다. 예를 들어, 80% 이상의 테스트 세트 점수를 얻으려면 STRAGO는 10개의 프롬프트만 탐색하면 되는 반면, APO와 같은 방법은 90개 이상의 프롬프트가 필요합니다. 이러한 빠른 수렴은 STRAGO가 다른 방법보다 더 가치 있는 참조 정보를 제공하기 때문일 수 있습니다. 단일 최적화 주기에서 옵티마이저는 긍정적인 경험과 부정적인 경험을 활용할 뿐만 아니라 해당 전략을 통합합니다. 이 접근 방식을 통해 옵티마이저는 보다 포괄적인 정보에 액세스하고 일반화 기능이 향상된 프롬프트를 생성할 수 있습니다.

[4.4 Cost Analysis]

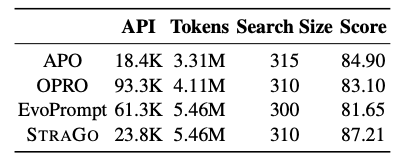

API 호출 수와 총 토큰 사용량을 추정하여 STRAGO의 리소스 소비량과 기본 방법의 리소스 소비량을 비교합니다(자세한 추정 방법은 부록 B 참조). TREC 데이터 세트에 대한 결과는 표 4에 나와 있습니다.

그림에서 볼 수 있듯이 APO는 API 호출이 가장 적고 STRAGO가 그 뒤를 잇습니다. 이 두 가지 방법 모두 OPRO 및 EvoPrompt와 달리 UCBandit 알고리즘을 활용하여 많은 후보 프롬프트를 필터링하므로 검증 세트에 대한 평가 비용을 절감할 수 있습니다.

토큰 소비 측면에서 EvoPrompt와 STRAGO의 사용량이 가장 높습니다. EvoPrompt의 소비 증가는 검증 세트에서 수많은 후보 프롬프트를 평가해야 하기 때문에 발생하는 반면, STRAGO의 사용량이 높은 것은 다른 방법에 비해 최적화된 프롬프트의 길이가 길기 때문입니다. 그러나 다른 방법에 비해 STRAGO의 성능이 크게 향상(84.90%에서 87.21%로)된 점을 고려할 때 이러한 리소스 지출은 정당한 것으로 간주됩니다.

[4.5 Performance Using Different Models]

GPT-3.5-터보 및 GPT-4를 평가자(즉각 성능을 평가하는 데 사용되는 작업 모델)로 사용하여 STRAGO 및 베이스라인 방법을 평가하고, GPT-4는 최적화자(즉각 성능을 향상시키는 데 사용되는 모델)로도 사용합니다. 실험 결과는 표 6에 보고되어 있습니다. STRAGO는 GPT-3.5-터보에서 5.45%, GPT-4에서 10.34%의 성능 개선을 달성했습니다. 또한 STRAGO는 GPT-3.5-터보에서 1.86%, GPT4에서 2.37%의 성능 향상을 달성했습니다. 이는 STRAGO가 더 고급 모델에서 더 나은 성능을 발휘한다는 것을 시사합니다. GPT-4에서 관찰된 우수한 성능은 정교하게 조정된 전략적 프롬프트에도 불구하고 특정 명령어 뉘앙스를 포착하는 데 어려움을 겪는 것으로 보이는 GPT-3.5-터보에 비해 지침에 대한 준수가 향상되었기 때문일 수 있습니다. 이러한 현상은 다른 연구에서도 언급되었습니다(Zeng 외, 2023; Ma 외, 2024). 자세한 결과는 부록 C에서 확인할 수 있습니다.

[5. Case Study]

이 섹션에서는 표 5에 자세히 설명된 견인 사례를 통해 리파이너가 개발한 전략과 옵티마이저가 수행한 최적화 프로세스에 대한 심층적인 검토를 제공합니다.

첫 번째 사례는 영화 추천 작업에 관한 것입니다. 이 시나리오에서 분석기는 프롬프트의 실패를 식별하여 명확한 유사성 기준이 없기 때문이라고 설명합니다. 이를 수정하기 위해 리파이너는 특히 이상치 데이터를 면밀히 조사하여 이러한 기준을 식별하는 데 중점을 둔 전략을 개발합니다. 그런 다음 옵티마이저는 이 진단된 오류를 해결하고 전략적 인사이트를 통합하여 프롬프트를 개선합니다.

두 번째 사례는 분석기가 특정 단어나 구와 같은 맥락적 단서에 집중하는 것의 중요성을 강조하는 스낙스 작업과 관련이 있습니다. 그런 다음 정제기는 이러한 기본 경험 인사이트를 통합할 뿐만 아니라 문장 톤, 특히 과장 또는 과장을 식별하기 위한 분석을 강조하는 전략을 작성합니다. 이러한 추가 인사이트는 문장의 아이러니한 의도를 결정하는 데 매우 중요합니다.

[6. Related Work]

[6.1 Automatic Prompt Engineering]

신속한 최적화는 특정 작업에 대한 가장 효과적인 프롬프트를 발견하는 것을 목표로 합니다(Sahoo et al., 2024; Liu et al., 2023). 초기에 이러한 최적화는 특히 복잡한 작업의 경우 노동 집약적인 전문가가 설계한 수작업 템플릿에 크게 의존했습니다(White et al., 2023). 이를 해결하기 위해 연구자들은 다양한 자동화된 최적화 기술을 개발했으며, 이를 위해 이산 및 연속 방법으로 광범위하게 분류되었습니다(Li and Liang, 2021; Zhang et al., 2021). 이산 최적화는 특정 토큰을 조정하여 프롬프트 텍스트를 수정합니다. 예를 들어, "단계별로 생각해 봅시다"와 같은 프롬프트를 "심호흡을 하고 이 문제를 단계별로 해결하세요"(Yang et al., 2023)로 수정할 수 있습니다. 반면, 연속 최적화는 임베딩 시작에 잠재 공간 벡터를 추가하여 프롬프트 임베딩을 조작합니다(Lester et al., 2021; Wen et al., 2023).

저희의 접근 방식인 스트라고는 추가 교육 없이도 개별 텍스트를 편집하는 데 중점을 둡니다.

[6.2 LLM-based Prompt Optimization]

최근 연구에서는 신속한 최적화를 위해 LLM을 점점 더 많이 활용하고 있습니다(저우 외, 2022). 몬테카를로 트리 검색(MCTS)(왕 외, 2023) 및 진화 알고리즘(궈 외, 2023; 페르난도 외, 2023)과 같은 고급 검색 기술을 사용하여 잠재적인 후보 프롬프트를 반복적으로 개선하고 통합하여 효과를 향상시킵니다. 또한 일부 연구에서는 잘못된 예제와 그 근본적인 원인을 분석하여 오류를 선제적으로 피하는 프롬프트를 생성하는 LLM의 자기 성찰 기능을 활용합니다(Pryzant 외, 2023; Yang 외, 2023; Ye 외, 2023; Tang 외, 2024). 이러한 성찰적 접근 방식을 통해 모델은 과거의 실수로부터 학습하여 미래 프롬프트의 정확성과 관련성을 모두 향상시킬 수 있습니다.

[7. Conclusion]

본 논문에서는 균형 잡힌 반복을 활용하여 성공 사례와 실패 사례를 모두 분석하는 전략 가이드, 성찰 기반 최적화 방법인 STRAGO를 소개합니다. 이 혁신적인 접근 방식은 목표를 달성하기 위한 중요한 요소를 식별하는 동시에 실패 이유에 대한 인사이트를 제공합니다. STRAGO는 컨텍스트 내 학습을 활용하여 신속한 최적화를 위한 세부 단계별 지침을 제공합니다. 단순 시나리오부터 도메인별, 복잡한 산업 컨텍스트에 이르기까지 다양한 작업에 걸쳐 수행된 실험은 STRAGO가 기존의 신속 최적화 방법을 크게 능가하여 현장에서 새로운 최첨단 기술을 확립한다는 것을 보여줍니다.

[8. Limitations]

우리의 한계는 다음과 같이 요약됩니다:

비교의 공정성: 공정한 비교를 위해 공식 기준 방법 코드의 특정 매개 변수를 조정하여 모든 방법의 검색 수를 약 300-315로 조정합니다. 검색 수에는 방법마다 약간의 차이가 있을 수 있지만, 이러한 차이는 비교 결과의 공정성을 유지하기 위해 허용 가능한 범위 내에서 최소화됩니다.

그러나 특정 작업의 경우 1600개의 검색을 초과한 후에도 OPRO와 같은 방법이 유의미한 성능 향상을 보이지 않을 것이라고 보장할 수 없다는 점에 유의하는 것이 중요합니다. 프롬프트 최적화의 주요 목표가 최적의 프롬프트를 효율적으로 식별하는 것이라는 점을 고려할 때, 각 방법의 전반적인 성능을 평가하기에 충분한 검색 제한은 300~315개로 간주됩니다.

모델 선택: 실험에서는 GPT-3.5-터보와 GPT-4를 작업 모델로 활용했습니다. 이와 같은 독점 모델은 업그레이드 또는 중단을 겪을 수 있으며, 잠재적으로 재현성에 문제가 될 수 있지만, 연구 결과에 따르면 스트라고는 더 고급 모델에서 더 효과적으로 성능을 발휘하는 것으로 나타났습니다. 따라서 더 새롭고 정교한 모델이 출시됨에 따라 스트라고는 여전히 경쟁력을 유지할 것으로 예상됩니다.