데이터 Pruning 작업을 제안. LLM을 파인튜닝하기 위해 최적의 데이터만 남긴다!

→ 이 선택된 데이터셋을 ‘코어셋(coreSet)’이라고 한다.

coreset은 보통 사람이 선택하거나 비효율적인 방법뿐이었다.

따라서, Pruning을 할때

- 모델에 영향을 많이 주는 영향력있는 데이터셋을 고르도록 하고,

- Pruning을 낮은 cost로 진행 하는 것을 목표로 한다.

이걸 위해서 이 논문에서는 아래 두가지 점수를 통합한 새로운 Pruning 방법을 제안한다.

- 영향력 점수(Influence score) : 각 샘플을 제거하는 것이 전체 성능에 미치는 영향을 정확하게 추정하기 위해 도입된다. → pruning의 cost를 낮추고, 영향력 점수를 얻기 위해 작은 크기의 대리 모델(Surrogate Model)을 사용한다.

- 노력 점수(effort score) : Surrogate model과 LLM의 잠재적인 격차를 고려하여, 일부 어려운 샘플을 LLM에 특별히 우선시 하기 위한 노력점수(effort score)를 추가로 제안.

⇒ 전체 데이터셋을 전부 파인튜닝하는 것보다 전체의 2% 데이터셋만 잘 골라내서 학습하면 시간이 97% 절감된다는 효과를 보였다!! 성능도 업 와우

이 연구에서는 LLM의 퓨샷 파인튜닝에 맞춘 대표 샘플을 골라내는 것을 목표로 한다!

코어셋 선택 방법 1. 휴리스틱 방법 : 경험적 위험에 미치는 영향을 추정하지 않음. → 최적의 코어셋 선택으로 이어짐.

코어셋 선택 방법 2. 최적화 기반 방법 : 경험적 위험을 최소화. → 복잡하고 비용이 많이 듬. 대규모 데이터셋에 적용 불가.

이 가지치기 방법을 ‘DEALRec (Data pruning method, to Efficiently identify the infludentiAl samples for LLM-based Recommender fine-tuning)’ 이라 명명한다.

Influence score : 체인 규칙과 2차 최적화 기법을 통해 영향 함수를 확장하여 계산된다.

모든 샘플에 대한 Influence score를 효율적으로 계산하기 위해 모든 샘플에 대해 한번만 추정한다.

그리고나서 전통적인 모델을 Surrogate model로 사용하여 Influence score를 얻고, surrogate model과 LLM 간의 격차를 줄이기 위해 effort score를 도입한다.

Effort score : 샘플 loss의 기울기를 계산하여 얻어지고, 특정 샘플에 맞추기 위해 LLM의 effort를 직관적으로 측정한다.

이후, Influence score를 effort score로 정규화함으로써 전체 데이터의 대표성과 LLM에 대한 중요성을 모두 포함하는 영향력 있는 샘플을 식별하게 된다.

아래부터는 논문 전체 번역본입니다.

[Abstract]

추천을 위해 대규모 언어 모델(LLM)을 활용하는 것은 최근 상당한 주목을 받고 있으며, 여기서 미세 조정은 LLM의 적응에 중요한 역할을 합니다. 그러나 빠르게 확장되는 추천 데이터에 대한 LLM의 미세 조정 비용은 실제 적용을 제한합니다. 이 문제를 해결하기 위해, 소수 샷 미세 조정은 새로운 추천 데이터에 LLM을 신속하게 적응시키는 유망한 접근 방식을 제공합니다. 우리는 효율적인 LLM 기반 추천을 위한 데이터 가지치기 작업을 제안하며, 이는 LLM의 소수 샷 미세 조정을 위해 맞춤화된 대표 샘플을 식별하는 것을 목표로 합니다. 코어셋 선택은 제안된 작업과 밀접한 관련이 있지만, 기존의 코어셋 선택 방법은 종종 최적이 아닌 휴리스틱 메트릭에 의존하거나 대규모 추천 데이터에 대한 비용이 많이 드는 최적화를 수반합니다.

이러한 문제를 해결하기 위해, 우리는 LLM 기반 추천의 맥락에서 데이터 가지치기 작업을 위한 두 가지 주요 목표를 소개합니다: 1) 높은 정확도는 높은 전체 성능을 이끌어낼 수 있는 영향력 있는 샘플을 식별하는 것을 목표로 하고, 2) 높은 효율성은 데이터 가지치기 과정의 낮은 비용을 강조합니다. 두 가지 목표를 추구하기 위해, 우리는 영향력 있는 샘플을 효율적으로 식별하기 위해 영향력 점수와 노력 점수라는 두 가지 점수를 통합한 새로운 데이터 가지치기 방법을 제안합니다. 특히, 영향력 점수는 각 샘플을 제거하는 것이 전체 성능에 미치는 영향을 정확하게 추정하기 위해 도입됩니다. 데이터 가지치기 과정의 낮은 비용을 달성하기 위해, 우리는 영향력 점수를 얻기 위해 작은 크기의 대리 모델을 사용합니다. 대리 모델과 LLM 사이의 잠재적인 격차를 고려하여, 일부 어려운 샘플을 LLM에 특별히 우선시하기 위한 노력 점수를 추가로 제안합니다. 우리는 두 개의 경쟁적인 LLM 기반 추천 모델에서 제안된 방법을 인스턴스화하고, 세 개의 실제 데이터셋에 대한 실증 결과를 통해 우리가 제안한 방법의 효과를 검증합니다. 특히, 우리의 방법은 전체 데이터 미세 조정을 능가하기 위해 단 2%의 샘플만을 사용하여 시간 비용을 97% 절감합니다.

[CCS CONCEPTS]

- Information systems -> Recommender systems.

[Keywords]

- Data Pruning, LLM-based Recommendation, Efficient Fine-Tuning

[1. Introduction]

추천을 위해 대형 언어 모델(LLM)을 활용하는 것은 클릭률(CTR) 예측 [4], 순차 추천 [35], 설명 가능한 추천 [11] 등 다양한 작업에서 유망한 효과를 입증했습니다. LLM 기반 추천 모델을 구축하기 위해서는 두 가지 주요 이유로 추천 데이터에 대한 LLM을 미세 조정하는 것이 중요합니다: 1) 이전 LLM의 조정 작업과 추천 작업 사이에 상당한 차이가 있습니다 [4]. 2) 추천 데이터의 신속하고 지속적인 업데이트를 위해서는 LLM의 빈번한 미세 조정이 필요합니다 [38]. 예를 들어, 하루에 약 1억 6천만 개의 새로운 동영상과 9,420억 개의 상호작용이 TikTok에 등장합니다. 따라서 최신 항목 정보를 통합하고 사용자 행동 이해를 높이기 위해서는 빈번한 미세 조정이 필수적입니다.

그러나 대규모 추천 데이터에서 LLM을 미세 조정하려면 상당한 계산 자원과 시간 비용이 필요합니다[26]. 따라서 실제 응용 분야에서 LLM 기반 추천 모델의 실용성이 떨어집니다. 따라서 LLM 기반 추천 모델의 미세 조정 효율성을 높이는 것이 필수적입니다.

다행히도 LLM에 인코딩된 풍부한 세계 지식은 효율적인 미세 조정을 위한 유망한 솔루션인 몇 샷 미세 조정을 제공합니다.

이전 연구들은 LLM이 무작위로 샘플링된 소수 샷 데이터 [3, 4, 27](그림 1(a))를 미세 조정하여 추천 작업에 빠르게 적응할 수 있는 잠재력을 가지고 있음을 발견했습니다. 이는 훈련 시간과 계산 비용을 크게 줄여줍니다. 효율성에도 불구하고, 무작위로 샘플링된 데이터는 LLM이 새로운 항목과 사용자 행동을 효과적으로 이해할 수 있도록 충분한 대표성을 결여할 수 있습니다. 이 문제를 해결하기 위해, 우리는 효율적인 LLM 기반 추천을 위한 데이터 가지치기 작업을 소개합니다. 이 작업은 LLM의 소수 샷 미세 조정에 맞춘 대표 샘플을 식별하는 것을 목표로 합니다.

이 데이터 가지치기 작업과 밀접하게 관련된 문헌 중 하나는 코어셋 선택입니다 [13]. 이는 전체 데이터에서 작지만 대표적인 하위 집합을 선택하여 유사한 성능을 달성하려고 합니다. 기존의 코어셋 선택 방법은 일반적으로 두 가지 범주로 나뉩니다2 : 1)

휴리스틱 방법은 미리 정의된 지표를 기반으로 단단하거나 다양한 샘플을 선택합니다 [30, 34, 49]. 이러한 휴리스틱 방법은 선택된 샘플이 경험적 위험에 미치는 영향을 추정하지 않으며, 이는 최적의 코어셋 선택으로 이어질 수 있습니다. 2) 최적화 기반 방법은 주로 경험적 위험을 최소화하기 위해 하위 집합 선택을 최적화합니다 [5, 50]. 그러나 이러한 방법은 복잡하고 비용이 많이 드는 이중 수준 또는 이산 최적화 문제로 인해 대규모 추천 데이터셋에는 적용할 수 없습니다 [17]. 더 나쁜 점은 휴리스틱 및 최적화 기반 방법 모두 전체 데이터에 의해 잘 훈련된 모델에 의존하여 코어셋을 선택하는 것입니다. 예를 들어, 사전 정의된 점수를 계산하거나 잘 훈련된 모델을 기반으로 데이터 하위 집합을 최적화하는 것입니다 (참조).

섹션 2). 따라서 대규모 전체 추천 데이터에 대한 LLM의 높은 훈련 비용 때문에 이러한 방법을 LLM 기반 추천에 직접 적용하는 것은 불가능합니다.

위의 문제를 극복하기 위해, 우리는 LLM 기반 추천의 맥락에서 데이터 가지치기의 두 가지 주요 목표를 요약합니다: 1) 낮은 경험적 위험을 초래할 수 있는 샘플을 선택하는 데 중점을 둔 높은 정확도와 2) 데이터 가지치기 과정의 낮은 비용을 강조하는 높은 효율성, 즉 전체 데이터에 대한 잘 훈련된 LLM의 의존성을 제거하는 것입니다. 그럼에도 불구하고, 두 가지 목표를 추구하는 것은 두 가지 도전 과제에 직면해 있습니다:

1. 높은 정확도를 달성하기 위해서는 각 훈련 샘플을 제거하는 것이 경험적 위험에 미치는 영향을 측정하는 것이 필수적입니다. 그러나 모든 샘플의 영향을 평가하는 것은 비용이 많이 듭니다. 왜냐하면 각 샘플에 대해 한 번만 재훈련을 해야 하기 때문입니다 (Tan et al., 2023).

2. 높은 효율성을 달성하기 위해, 하나의 가능한 해결책은 샘플 선택을 위한 대리 모델을 훈련시키는 것입니다. 예를 들어, 작은 크기의 전통적인 추천 모델을 사용하면 LLM에 비해 GPU 메모리 사용량과 훈련 시간을 크게 줄일 수 있습니다(그림 1(b)). 그러나 LLM과 대리 모델 사이에는 사용자 행동 학습 능력이 다르기 때문에 격차가 존재합니다(그림 5 참조). 따라서 대리 모델에 의해 선택된 영향력 있는 샘플은 LLM의 샘플과 다를 수 있으며, 이는 잠재적으로 LLM의 적응을 저해할 수 있습니다.

이러한 문제를 해결하기 위해, 우리는 LLM 기반 추천자 미세 조정을 위한 영향력 있는 샘플을 효율적으로 식별하기 위한 새로운 데이터 가지치기 방법을 제안합니다(DEALRec (Data pruning method, to Efficiently identify the infludentiAl samples for LLM-based Recommender fine-tuning)). DEALRec은 영향력 있는 샘플을 식별하기 위해 영향력 있는 점수와 노력 점수라는 두 가지 점수를 활용합니다. 영향력 점수는 각 훈련 샘플을 제거하는 것이 경험적 위험에 미치는 영향을 추정하기 위해 공식화됩니다. 이는 체인 규칙과 2차 최적화 기법(Koh와 Lang, 2017)을 통해 영향 함수(Hampel, 1974)를 확장하여 계산됩니다. 모든 샘플에 대한 영향력 점수를 효율적으로 계산하기 위해 DEALRec은 간단하면서도 효과적인 대칭 속성을 사용하여 모든 샘플에 대해 한 번만 추정하면 됩니다(섹션 3.1 참조). 그 후, DEALRec은 전통적인 추천 모델을 대리 모델로 사용하여 영향력 점수를 얻고, 대리 모델과 LLM 간의 격차를 줄이기 위해 노력 점수를 도입합니다. 노력 점수는 샘플 손실의 기울기 노름을 계산하여 얻어지며, 특정 샘플에 맞추기 위해 LLM의 노력을 직관적으로 측정합니다. 영향력 점수를 노력 점수로 정규화함으로써 DEALRec은 전체 데이터의 대표성과 LLM에 대한 중요성을 모두 포함하는 영향력 있는 샘플을 식별합니다. 우리는 두 개의 LLM 기반 추천 모델에서 DEALRec을 인스턴스화하고, 세 가지 실제 데이터셋에서 광범위한 실험을 수행하여 효율성과 정확성 측면에서 DEALRec의 우수성을 검증합니다. 코드와 데이터셋은 https://github.com/Linxyhaha/DEALRec 에서 확인할 수 있습니다.

요약하자면, 이 작업은 세 가지 주요 기여를 제공합니다:

1. 효율적인 LLM 기반 추천기 미세 조정을 위해 맞춤화된 영향력 있는 샘플을 식별하기 위해 데이터 가지치기 작업을 도입하여, 실제 플랫폼에 LLM 기반 추천기 모델을 적용할 수 있는 놀라운 잠재력을 발휘합니다.

2. 우리는 LLM 기반 추천을 위한 영향력 있는 샘플을 발견하기 위해 새로운 데이터 가지치기 방법을 제안합니다. 이 방법은 샘플 제거가 경험적 위험에 미치는 영향을 효과적이고 효율적으로 평가합니다.

3. 우리는 세 개의 실제 데이터 세트에 대해 광범위한 실험을 수행하여 DALERec이 높은 효율성과 정확성을 모두 달성하는 데 효과적임을 입증했습니다.

[2. Task Formulation]

이 섹션에서는 먼저 LLM 기반 추천 모델을 소개하고 실제 적용 가능성에 대한 도전 과제를 밝혀냅니다. 그 후, LLM 기반 추천을 위한 데이터 가지치기 작업을 공식화하고 코어셋 선택에 관한 관련 작업을 비교합니다.

LLM 기반 추천 모델. LLM의 유능한 기능을 활용하기 위해, LLM 기반 추천은 일반적으로 강력한 LLM을 추천 모델로 직접 활용합니다. LLM은 추천 데이터에 대해 특별히 훈련되지 않기 때문에, 미세 조정은 LLM이 아이템 지식을 배우고 사용자 행동을 이해하는 데 필요한 중요한 단계입니다. Uand는 각각 사용자와 아이템의 집합을 주목합니다. 우리는 각 훈련 샘플, 즉 사용자 시퀀스를 𝑠 = (𝑥, 𝑦)로 제시합니다. 여기서 𝑥 = [𝑖1, 𝑖2,..., 𝑖|𝑥|]는 사용자의 시간 순서에 따른 역사적 상호작용을 의미하며, 𝑦는 {𝑖1,..., 𝑖|, 𝑦}⊂I}인 사용자3의 다음 상호작용 아이템입니다. 여기서 {𝑥1,..., 𝑖|, 𝑦}⊂I.

공식적으로, 훈련 세트 D= {𝑠𝑢|𝑢 ∈ U}의 사용자 시퀀스가 주어졌을 때, 목표는 추천 작업을 위해 LLM을 미세 조정하는 것입니다. LLM의 학습 가능한 매개변수(𝜙 ∈ φ)는 입력 𝑥를 조건으로 다음 상호작용 항목 𝑦의 부정적인 로그 가능성을 최소화하여 최적화됩니다:

여기서 𝑦𝑡는 𝑦의 𝑡 번째 토큰을 나타내고, 𝑦<𝑡는 𝑦𝑡 이전의 토큰 시퀀스를 나타냅니다.

LLM을 미세 조정하는 것이 추천 작업에서 효과적임을 입증했지만 [29], LLM이 요구하는 높은 자원 비용과 새로운 추천 데이터의 지속적인 유입으로 인해 실용적인 적용이 저해되고 있습니다 [38]. 따라서 LLM 기반 추천자 미세 조정의 효율성을 높이는 것이 필수적입니다.

효율적인 LLM 기반 추천을 위한 데이터 가지치기.

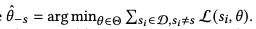

효율적인 LLM 기반 추천을 달성하기 위해 유망한 접근 방식은 무작위로 선택된 샘플 [4]을 사용하여 몇 번의 샷 미세 조정을 통해 비용을 절감하는 것입니다. 그럼에도 불구하고, 무작위 샘플은 LLM이 사용자 행동이나 트렌드 아이템과 같은 최신 정보를 획득하는 데 중요한 정보를 잃을 수 있습니다. 이러한 관점에서, 우리는 효율적인 LLM 기반 추천을 위한 데이터 가지치기 작업을 소개합니다. 이 작업은 특히 LLM의 몇 번의 샷 미세 조정을 위해 대표적인 샘플 세트를 식별하는 것을 목표로 합니다. 공식적으로, 모든 훈련 샘플 D= {𝑠𝑢|𝑢 ∈U}가 주어졌을 때, 데이터 가지치기의 목표는 하위 집합 S ⊂D를 선택하는 것이며, 이를 통해 하위 집합 스캔에서 훈련된 LLM이 테스트 세트에서 좋은 성능을 발휘합니다. 주어진 선택 비율 𝑟, 즉 |S|= 𝑟|D|에 의해 제어되는 Sis의 크기.

코어셋 선택의 회고. 이 데이터 가지치기 작업과 밀접하게 관련된 작업으로서, 코어셋 선택 방법은 일반적으로 두 그룹으로 나뉩니다:

1) 휴리스틱 방법 [7, 10, 44]은 일반적으로 경험적 최소화기를 기반으로 샘플을 선택하는 몇 가지 휴리스틱 전략을 설계합니다:

여기서 L(·)은 작업의 손실 함수로, 예를 들어 이미지 분류 [16] 또는 CTR 예측 [14]입니다. 𝐻(·)는 예측 엔트로피가 더 큰 샘플을 선택하거나 샘플 표현 [6]을 기반으로 샘플을 클러스터링하는 휴리스틱 전략을 의미합니다. 그러나 이 방법 그룹은 직관적으로 전략 𝐻(·)을 설계하고 샘플이 경험적 위험에 미치는 영향을 명시적으로 고려하지 않습니다. 이는 최적의 선택이 되지 않아 선택된 하위 집합에 의해 학습된 모델의 성능이 저하될 수 있습니다.

2) 최적화 기반 방법 [5, 22, 23, 48]은 주로 이중 수준 최적화 기법을 사용하여 훈련에 선택된 최적의 하위 집합을 학습합니다:

게다가, 방정식 (2)의 경험적 최소화 ˆ 𝜃을 기반으로 한 이산 최적화 문제를 사용하는 연구도 있습니다.

그럼에도 불구하고, 최적화 문제의 복잡한 해결로 인해 추천 데이터와 같은 대규모 데이터셋에 적용하는 데 어려움을 겪고 있습니다 [17].

또한, 방정식 (2-3)에 나타난 바와 같이, 이전의 코어셋 선택 방법들은 일반적으로 원래의 훈련 샘플 D에 대해 모델을 훈련시켜야 하지만, 데이터의 지속적인 유입과 LLM의 높은 자원 비용으로 인해 LLM 기반 추천 모델에서는 실행 불가능합니다 (섹션 1 참조).

• 위의 인사이트를 바탕으로, 우리는 데이터 가지치기를 위한 두 가지 목표를 고려합니다: 1) 높은 정확도는 선택된 샘플에 대해 훈련된 모델의 낮은 경험적 위험을 강조하고, 2) 높은 효율성은 데이터 가지치기 과정의 낮은 비용에 중점을 두어, 데이터 가지치기를 위한 LLM의 과도한 미세 조정에서 벗어납니다.

[3. DEALRec]

효율적인 LLM 기반 추천을 추구하기 위해, 우리는 경험적 위험에 대한 영향을 추정하기 위한 영향 점수와 대리 모델과 LLM 간의 격차를 완화하기 위한 정규화로서의 노력 점수라는 두 가지 주요 구성 요소를 포함하는 새로운 데이터 가지치기 방법 DALERec을 제안합니다. 우리 방법의 개요는 그림 2에 제시되어 있습니다.

[3.1 Influence Score]

가지치기된 데이터셋 S에서 훈련된 모델로 전체적으로 좋은 성능을 달성하기 위해서는 훈련 중인 샘플을 제거함으로써 발생하는 경험적 위험, 즉 전체 성능에 미치는 영향을 평가할 수 있는 능력에 핵심이 있습니다. 그러나 단순히 각 샘플을 제거하여 영향을 평가하는 것은 비현실적입니다. 왜냐하면 𝑛 = |D|times에 대해 무차별 대입을 제외한 retr 훈련이 필요하기 때문입니다. 이 문제를 극복하기 위해, 우리는 체인 규칙과 2차 최적화 기법을 통해 매개변수 변화(즉, 영향 함수 [24]의 고전적인 결과)에 대한 영향을 확장하여 모든 샘플에 대한 영향을 효율적으로 근사하는 방법을 제안합니다. 또한, 대칭 속성을 활용하여 영향 점수 계산 속도를 높입니다.

• 매개변수 변화에 대한 영향. 각 샘플에 대한 경험적 위험에 대한 영향을 추정하기 위해 먼저 영향 함수 [8]에 대한 연구의 고전적인 결과 [28]로 시작하여, 훈련을 위한 샘플 𝑠의 가중치를 상향 조정하여 발생하는 매개변수 변화를 추정할 수 있습니다. 훈련 샘플 𝑠가 작은 𝜖만큼 상향 조정된다는 점을 고려하면, 경험적 최소값은 다음과 같이 다시 쓸 수 있습니다:

[28]에 따르면, 샘플 𝑠의 가중치를 높이는 것이 매개변수 변화에 미치는 영향은 다음과 같이 주어집니다:

는 가정에 의해 헤시안 및 양의 정칙, Iparam (𝑠)∈R 𝑚, 𝑚는 매개변수의 수입니다. 특히, 할당 - 1

𝑛 대 𝜖은 훈련에서 샘플 𝑠를 제거하는 것과 같습니다. 따라서 훈련 샘플 𝑠를 제거하는 매개변수 변화는 다음과 같이 선형적으로 근사할 수 있습니다:

방정식 (6)을 기반으로 모델 학습에 대한 샘플의 영향을 평가하는 직관적인 접근 방식은 [50]에서 제안된 바와 같이 매개변수 변경 또는 추가 이산 최적화 문제에 대한 샘플의 영향을 L2 노름으로 활용하는 것입니다. 그럼에도 불구하고 매개변수 변경이 크다고 해서 반드시 성능이 향상되는 것은 아닙니다. 또한, 모든 학습 샘플에 대해 방정식 (6)을 계산하는 것은 계산 비용이 많이 들 수 있으며 [17] 추천 데이터에서는 불가능합니다. 이러한 문제를 완화하기 위해, 우리는 샘플 제거가 경험적 위험에 미치는 영향에 대한 효율적인 근사치를 제안합니다.

경험적 위험에 미치는 영향. 영향 함수를 통해 얻은 매개변수 변화를 바탕으로, 훈련 샘플 𝑠에 작은 𝜖로 가중치를 부여하는 것이 임의의 샘플 𝑠'의 손실에 미치는 영향을 추정할 수 있습니다:

마찬가지로, 훈련 샘플 𝑠를 제거하는 것이 임의의 샘플 𝑠'의 손실에 미치는 영향은 다음과 같이 선형적으로 근사할 수 있습니다:

그런 다음 샘플 𝑠를 제거하면 경험적 위험(즉, 영향 점수)에 미치는 영향을 얻을 수 있습니다.

그러나

를 형성하고 반전하려면 𝑛 훈련 샘플과 𝜃 ∈ R 𝑚를 사용하여 O(𝑛𝑚2 + 𝑚3)가 필요하므로 직접

를 얻는 것은 간단하지 않습니다. 이로 인해 모든 훈련 샘플에 대한 영향 점수를 계산하는 데 번거롭습니다.

영향력 점수의 효율적인 추정.

영향력 점수의 효율적인 계산을 위해 확률 기반 헤시안 벡터 곱(HVP) [1]을 사용하여

를 효율적으로 근사합니다.

확률 기반 HVP 추정의 아이디어는

의 편향되지 않은 추정치를 반복적으로 구하고 HVP의 편향되지 않은 추정치, 즉

에 접근하는 것입니다. 구체적으로, 명확성을 위해 ˆ 𝜃 첨자를 생략하고 𝐻-1의 테일러 전개에서 첫 번째 𝑗 항을 D로 작성합니다. 이 항은 E로 재귀적으로 다시 작성될 수 있습니다. 테일러 전개의 유효성으로부터, 우리는 𝑗 -1 𝑗 →𝐻로서 𝐻-1 ∞→ ˆ 𝜃을 가집니다. 그 후, ∇𝜃 L(𝑠, 𝑡)을 𝑣로 나타내어, 𝑡 단계에서 추정된 F에 대한 업데이트 반복을 다음과 같이 작성할 수 있습니다:

여기서 𝑠𝑡은 D에서 무작위로 추출한 훈련 샘플이고,

는 빠르게 계산할 수 있는 HVP를 위해 단계 𝑡에서 𝐻의 편향되지 않은 추정치입니다 [24].

확률 기반 HVP가 추정의 계산 부담을 완화할 수 있음에도 불구하고, 각 𝑠 ∈ D에 대한

의 독립적인 𝑛 추정으로 인해 각 샘플에 대한 영향 점수를 계산하는 것은 여전히 비용이 많이 듭니다(식 (9) 참조).

모든 샘플에 대한 영향력 점수 획득의 효율성을 더욱 높이기 위해 대칭 속성을 사용하여 방정식 (9)를 다음과 같이 다시 작성합니다:

재구성은 L(·)이 연속적인 2차 도함수를 가지고 있다는 가정에 기초하고 있으며, 이는 영향 함수 [24]에 대한 가정과 일치하여 𝐻-1이라는 사실로 이어집니다

𝜃은 대칭입니다.

는 모든 샘플 𝑠 ∈D에 대해 상수 벡터이므로

에 대해 한 번만 HVP 추정을 적용하면 모든 샘플에 대한 영향 점수를 효율적으로 얻을 수 있습니다. 자세한 HVP 추정 프로세스는 알고리즘 1에 설명되어 있습니다.

[3.2 Gap Regularization]

방정식 (11)에 나타난 바와 같이, 샘플 모델의 영향 점수를 평가합니다.

모든 훈련 샘플 D에 대해 최적화된 매개변수를 ˆ 𝜃 잘 훈련해야 합니다. 그럼에도 불구하고, 이는 실제 시나리오에서 대규모 신규 데이터의 지속적인 유입으로 인해 LLM 기반 추천 모델에 도전 과제를 제기합니다. 이러한 관점에서, 우리는 LLM을 대체하기 위해 대리 모델을 활용하고, LLM과 대리 모델 간의 학습 능력 격차를 보완하기 위해 노력 점수를 갭 정규화로 도입할 것을 제안합니다.

• 대리 모델. 비용을 줄이기 위해, 우리는 대리 모델, 예를 들어 소규모 전통 추천 모델을 활용하여 영향력 점수를 계산할 것을 제안합니다. 그럼에도 불구하고, LLM은 사전 훈련 단계에서 풍부한 세계 지식을 습득하기 때문에 대리 모델과 복잡하게 다른 학습 능력을 가지고 있습니다 (그림 3(a)). 따라서 LLM에 대한 영향력 있는 샘플은 LLM에 대한 샘플과 다를 수 있습니다.

• 노력 점수. 격차를 보완하기 위해 특히 LLM의 중요한 샘플을 캡처하는 것을 목표로 하는 노력 점수를 도입합니다. 구체적으로, 샘플, 즉 사용자 시퀀스 𝑠의 노력 점수를 다음과 같이 정의합니다:

여기서 𝜙은 LLMs5의 학습 가능한 매개변수입니다. 직관적으로 이는 특정 사용자 시퀀스에 맞추기 위한 LLM의 학습 노력을 측정하며, 점수가 높을수록 LLM이 학습하기 어려운 샘플임을 나타냅니다. 자세히 설명하자면, 방정식 (12)는 모델 매개변수의 변화를 측정하는데, 이는 LLM의 매개변수에 인코딩된 현재 지식과 최신 항목 지식 또는 사용자 행동의 차이로 해석될 수 있습니다. 따라서 노력 점수는 특히 LLM의 경우 유의미한 샘플을 강조할 수 있으며, 이는 대리 모델의 다양한 학습 능력을 보완합니다(그림 3(b)).

• 전체 점수. LLM의 학습 능력 신호를 영향 점수 계산에 주입하면 LLM 기반 추천자 미세 조정을 위한 각 사용자 시퀀스의 최종 점수를 얻을 수 있습니다:

여기서 𝜆은 갭 정규화의 강도를 균형 있게 맞추기 위한 하이퍼파라미터입니다. 특히 갭 정규화는 더 작은 노력 점수를 가진 쉬운 샘플을 억제하는 동시에 더 배우기 어려운 샘플, 즉 더 큰 노력 점수를 강조합니다.

직관적으로 DALERec은 두 가지 주요 고려 사항을 통해 영향력 있는 샘플을 식별합니다: 1) 영향력 점수는 전체 데이터셋에서 대표 샘플을 선택하고, 낮은 경험적 위험을 위해 협업 필터링 정보를 캡처하는 데 중점을 둡니다. 2) 노력 점수는 LLM 학습에 중요한 비자명한 샘플을 강조합니다. 두 점수의 효과는 섹션 4.3.1에서 실증적으로 검증되었습니다.

[3.3 Few-shot Fine-Tuning]

방정식 (13)을 통해 얻은 최종 영향력 점수를 바탕으로, 예상 선택 비율 𝑟이 주어졌을 때 LLM의 몇 샷 미세 조정을 위한 데이터 S의 하위 집합을 선택할 수 있습니다.

- 소수 샷 데이터 커버리지. 간단한 접근 방식은 데이터를 탐욕스럽게 선택하는 것, 즉 전체 점수를 기준으로 샘플의 순위를 매긴 다음 학습 데이터의 상위 𝑟 비율을 선택하는 것입니다.

그러나 점수가 높은 샘플을 탐욕스럽게 선택하면 데이터 커버리지가 낮은 매우 유사한 샘플이 나올 수 있으며, 이는 다음과 같은 결과를 초래할 수 있습니다: 1) 다른 영역의 샘플이 부적절하여 제한된 경험적 위험을 초래하고 [57] 전체 성능을 저하시킵니다 (섹션 4.2 참조). 2) 유사한 패턴을 가진 중복 샘플로 인해 훈련 샘플의 활용도가 낮아져 몇 샷 미세 조정을 위한 최적의 선택이 이루어지지 않습니다.

- 커버리지 강화 샘플 선택. 위의 문제를 해결하기 위해, 우리는 [57]을 따라 계층화된 샘플링 아이디어를 바탕으로 사용자를 선택합니다. 핵심 아이디어는 훈련 분포의 다양한 영역에서 샘플 예산을 유지하여 데이터 커버리지를 개선하여 경험적 위험에 대한 높은 확률 한계를 보장하는 것입니다(자세한 증명은 [57]을 참조하십시오). 구체적으로, 먼저 샘플을 전체 점수에 따라 𝐾 그룹으로 나눕니다. 그런 다음 샘플 수가 가장 적은 그룹에서 𝑛𝑠 사용자 시퀀스를 반복적으로 샘플링하고 샘플링 후 해당 그룹을 폐기합니다. 여기서 𝑛𝑠은 모든 그룹의 평균 샘플링 예산이며 ⌊𝑟|D| 𝐾 ⌋로 초기화됩니다. 그룹 크기가 평균 샘플링 예산보다 작은 경우, 우리는 이 그룹에서 모든 사용자를 선택하고 나머지 그룹의 평균 샘플링 예산을 업데이트합니다(알고리즘 2 참조).

선택된 소수 샷 샘플 S를 기반으로 LLM의 학습 가능한 매개변수(𝜙 ∈ φ)를 최적화합니다:

- 인스턴스화. LLM 기반 추천 모델에서 DALERec을 인스턴스화하기 위해, 먼저 대리 모델을 사용하여 원래 훈련 샘플을 학습시키고, 모든 샘플에 대한 영향 점수를 계산합니다. 여기서 L(·)는 대리 모델로부터 손실 함수의 어떤 형태든지 될 수 있습니다. 예를 들어, BPR [37]. 그런 다음, Equ. (12)를 통해 LLM에 대한 노력 점수를 얻습니다. 여기서 𝜙는 백엔드 LLM 기반 추천 모델로부터 학습 가능한 매개변수가 될 수 있습니다.

결국, 우리는 계층화된 샘플링을 적용하여 LLM의 몇 샷 미세 조정을 위한 샘플을 선택합니다. DALERec의 자세한 데이터 가지치기 과정은 알고리즘 2에서 시연됩니다.

[4. Experiment]

우리는 다음 연구 질문에 답하기 위해 세 가지 실제 데이터셋에 대해 광범위한 실험을 수행합니다: -RQ1: 제안된 DALERec은 LLM 기반 추천을 위한 핵심 세트 선택 기준 및 전체 데이터로 학습된 모델과 비교하여 어떻게 성능이 향상됩니까?

-RQ2: DALERec의 다양한 구성 요소(즉, 영향 점수, 격차 정규화 및 계층화 샘플링)가 성능에 어떤 영향을 미치며, DALERec은 다양한 대리 모델에 일반화될 수 있습니까?

-RQ3: 다양한 선택 비율에서 DEALRec은 어떻게 성과를 내고 있으며, DEALRec은 전체 성과를 어떻게 향상시키나요?

[4.1 Experimental Settings]

4.1.1 데이터셋. 우리는 세 가지 실제 추천 데이터셋에 대한 실험을 수행합니다: 1) 게임은 사용자와 풍부한 텍스트 기능을 가진 비디오 게임 간의 상호작용을 다루는 Amazon 리뷰 데이터셋6에서 가져온 것입니다. 2) MicroLens-50K7은 새로 출시된 마이크로 비디오 추천 데이터셋 [33]입니다. 이 데이터셋에는 50명의 𝑘 사용자와 마이크로 비디오 및 관련 다중 모드 기능 간의 상호작용이 포함되어 있습니다. 3) 책도 Amazon 리뷰 데이터셋에서 가져온 것으로, 사용자와 광범위한 책 간의 상호작용을 포함하고 있습니다. Games와 Book의 경우, 이전 연구를 따르며 평점이 < 4인 상호작용은 폐기합니다. 세 가지 데이터셋에 대해, 우리는 모든 사용자-아이템 상호작용을 글로벌 타임스탬프에 따라 정렬한 다음, 상호작용을 8:1:1의 비율로 훈련, 검증 및 테스트 세트로 나눕니다.

게다가, 우리는 다음과 같은 두 가지 다른 미세 조정 설정을 고려합니다:

1) 소수 샷 미세 조정 LLM 기반 추천 모델은 고정된 크기(예: 1024 샷)에서 제한된 샘플을 사용하여 다양한 데이터 가지치기 방법을 통해 얻습니다. 2) 전체 미세 조정은 모든 샘플을 활용하여 데이터 가지치기 없이 LLM 기반 추천 모델을 미세 조정합니다.

4.1.2 기준선. 우리는 DALERec을 무작위 샘플링 및 여러 경쟁적인 코어셋 선택 방법과 비교합니다. 여기에는 난이도 기반 방법과 다양성 기반 방법이 포함됩니다: 1) 랜덤은 데이터 효율적인 훈련에서 인기 있고 강력한 기준선인 랜덤 샘플링을 통해 데이터 하위 집합을 얻습니다 [13]. 2) GraNd [34]는 훈련 중에 더 큰 기울기 노름을 가진 어려운 샘플을 선택하는 대표적인 코어셋 선택 방법입니다. 3) EL2N [34]은 원래 데이터셋으로 훈련된 모델에서 레이블과 예측 간의 오차가 큰 어려운 샘플을 선택할 것을 제안합니다. 4) CCS [57]는 높은 데이터 커버리지와 샘플 중요도를 모두 고려하여 샘플을 선택하는 경쟁적인 방법입니다. 우리는 CCS의 중요도 지표로 EL2N을 사용합니다. 5) TF-DCon [49]은 최근 제안된 콘텐츠 기반 추천을 위한 데이터 가지치기 방법으로, 잘 훈련된 추천 모델과 선택을 위한 LLM에서 얻은 사용자 표현을 기반으로 사용자 시퀀스를 클러스터링합니다. 6) Recranker [30]은 고품질 사용자 시퀀스를 선택하기 위한 샘플링 전략을 제안합니다. 더 나은 사용자 모델링을 위해 더 많은 상호작용을 가진 사용자를 선택하고 사용자 다양성을 높이기 위해 클러스터 기반 샘플링 전략을 활용합니다.

대규모 추천 데이터에서 LLM에 대한 복잡한 이중 수준 또는 이산 최적화가 적용되지 않기 때문에 비교를 위해 최적화 기반 방법을 수행하지 않습니다(참조).

섹션 2). 우리는 두 가지 경쟁 백엔드 LLM 기반 추천 모델에서 제안된 DALERec과 모든 기준선을 인스턴스화합니다: 1) BIGRec [3]은 아이템 제목을 활용하여 추천 생성을 위한 사용자 시퀀스를 제시합니다; 2) TIGER [35]는 아이템 특징에서 아이템을 제시하기 위해 추가 토큰을 학습한 후, 사용자 시퀀스를 새로운 아이템 토큰의 시퀀스로 변환하여 다음 아이템 생성을 수행합니다.

• 평가. 우리는 널리 사용되는 지표인 Recall@𝐾와 NDCG@𝐾를 사용하여 모델 [18]을 평가합니다. 게임의 경우 𝐾을 10과 20으로 설정하고, MicroLens-50K와 Book8의 경우 𝐾=을 20과 50으로 설정했습니다.

4.1.3 구현. 두 가지 백엔드 LLM 기반 추천 모델의 경우, 우리는 구현을 위해 논문의 원래 설정을 따릅니다. 논문 [35]에서와 같이 BIGRec에는 LLaMA-7B를, TIGER에는 트랜스포머 기반 아키텍처를 사용합니다.

모든 미세 조정 실험은 네 대의 NVIDIA RTX A5000 GPU에서 수행됩니다. 또한, 우리는 BIGRec을 미세 조정하고 TIGER의 매개변수를 완전히 미세 조정하기 위해 매개변수 효율적인 미세 조정 기법인 LoRA [19]를 채택했습니다. 우리는 DALERec에서 대표적인 순차 추천 모델인 SASRec [20]을 대리 모델로 사용합니다.

HVP 추정을 위한 반복 횟수 𝑇를 5000으로 설정하고, {0.1,0.3,0.5,1.0,2.0}에서 정규화 강도 𝜆를 검색합니다. 클러스터 기반 방법의 경우, {25,50,75}에서 클러스터 𝐾의 수를 탐색합니다. LLM의 학습이 필요한 코어셋 선택 방법에 대해서는 DALERec과 동일한 대리 모델에서 실행하여 [7]을 구현하는 것이 가능하다고 생각합니다.

[4.2 Overall Performance (RQ1)]

소수 샷 미세 조정(1024개 샘플) 하에서 세 가지 데이터 세트에 대한 두 가지 경쟁 백엔드 LLM 기반 추천 모델을 사용한 기준선 및 DALERec의 결과는 표 2에 제시되어 있으며, 이를 통해 다음과 같은 관찰 결과를 얻을 수 있습니다:

BIGRec을 사용하는 모든 방법은 일반적으로 TIGER을 사용하는 방법보다 더 나은 성능을 제공하는데, 이는 두 가지 이유에 기인합니다: 1) BIGRec은 TIGER에 비해 더 큰 LLM(즉, LLaMA-7B)을 사용하여 대규모 LLM[27]의 강력한 일반화 능력을 활용합니다. 2) BIGRec은 아이템 제목을 활용하여 사용자 시퀀스를 제시함으로써 LLM에서 세계 지식을 더 잘 활용할 수 있습니다. 반면, TIGER는 LLM을 위한 추가 아이템 토큰을 학습합니다. 이는 제한된 아이템 토큰만 학습되고 다른 아이템 토큰은 몇 샷 미세 조정 설정 하에서 무작위로 초기화되어 있기 때문에 콜드 스타트 아이템 문제를 초래할 수 있습니다.

-모든 코어셋 선택 기준 중에서 난이도 기반(GraNd, EL2N) 방법이 일반적으로 다양성 기반 방법(TF-DCon, RecRanker)보다 더 나은 성능을 보입니다. 이는 다양성 기반 방법이 단순히 다양한 선호도를 가진 사용자를 선택하도록 휴리스틱적으로 장려하기 때문에 합리적입니다. 이는 모델 학습에 대한 기여도에 대한 평가가 부족합니다. 반면, GraNd와 EL2N은 사전 정의된 지표를 사용하여 샘플 난이도를 측정하고 점수가 높은 샘플을 선택하므로 모델 최적화에 더 유익한 샘플을 선택하도록 권장합니다. 또한, CCS는 대부분의 경우 EL2N을 개선하여 선택하기 쉬운 샘플을 유지함으로써 고밀도 지역의 추천 데이터에 대한 지식을 보완합니다.

또 다른 흥미로운 관찰은 무작위 샘플링이 경쟁력 있는 성능을 제공하거나 경우에 따라 다른 코어셋 선택 방법을 능가한다는 점입니다. 이는 두 가지 가능한 이유에 기인할 수 있습니다: 1) 균일하게 선택된 사용자 시퀀스는 다른 기준선에 비해 원래 훈련 분포의 높은 커버리지를 유지하며, 이는 낮은 경험적 위험에 대한 높은 보장 범위를 보장합니다 [57]. 이 관찰은 [13]의 결과와도 일치합니다. 2) 일부 코어셋 선택 방법의 성능 저하는 구현 설정(섹션 4.1.3)에서도 발생할 수 있으며, 이는 대리 모델과 LLM 간의 학습 능력 격차로 인해 발생할 수 있습니다(섹션 3.2 참조).

-DEALRec는 세 가지 데이터셋에서 모든 코어셋 선택 방법을 크게 능가합니다. 두 백엔드 모델의 일관된 성능 향상은 LLM의 추천 데이터 적응에 영향력 있는 샘플을 식별하는 데 있어 DEALRec의 우수성을 입증합니다. 우수한 성능은 다음과 같습니다: 1) 경험적 위험에 대한 영향을 정확하고 효율적으로 추정하는 것, 즉 훈련 중인 샘플을 제거하여 전체 성능을 향상시키는 것; 2) LLM의 쉬운 샘플에 불이익을 주기 위한 노력 점수에 기반한 갭 정규화. 특히 LLM의 경우 비자명한 샘플을 강조함으로써 갭 정규화는 대리 모델과 LLM 간의 학습 능력 격차를 완화합니다.

전체 미세 조정과의 비교. 우리는 또한 표 3에 제시된 바와 같이 정확성과 효율성을 바탕으로 DALERec을 BIGREC과 비교합니다. 우리는 다음과 같은 결과를 얻을 수 있습니다: 1) DALERec은 전체 데이터로 학습된 모델에 비해 더 높은 성능을 달성하여 높은 정확성을 위한 DALERec의 효과를 나타냅니다.

완전한 훈련 하에서 BIGRec의 성능이 떨어진다는 것은 모든 사용자 시퀀스가 모델 훈련에 유익하거나 심지어 훈련에 해로운 것은 아니라는 것을 의미합니다. 예를 들어, 잘못된 부정적 상호작용이 있습니다.

이는 CTR 예측 [48]에서도 관찰되었으며 데이터 중복성 관점에서 [2]에서 논의되었습니다. 2) DALERec은 LLM의 미세 조정 시간 비용을 크게 절감합니다(평균적으로 미세 조정 비용을 97.11% 절감). 교육 비용이 현저히 감소함에 따라 DALERec은 LLM 기반 추천 모델의 실제 적용을 촉진할 수 있는 잠재력을 가지고 있습니다.

[4.3 In-depth Analysis]

4.3.1 절제 연구(RQ2). DALEXRec의 각 구성 요소, 즉 영향 점수, 노력 점수 및 커버리지 강화 샘플 선택 전략의 효과를 연구하기 위해, 우리는 각각 "w/o IS"와 "w/o 𝛿𝑠"로 불리는 영향 점수(IS)와 노력 점수 𝛿𝑠를 별도로 제거합니다. 또한, 커버리지 강화 샘플 선택 전략을 "Greedy"로 표시된 더 높은 점수를 가진 샘플을 탐욕스럽게 선택함으로써 대체합니다. 그림 4에 제시된 결과로부터, 우리는 다음을 관찰할 수 있습니다: 영향 점수 또는 노력 점수를 제거하면 성능 저하가 발생할 수 있습니다. 이는 1) 훈련에서 샘플을 제거함으로써 발생하는 전반적인 성능 변화 평가의 효과를 검증합니다; 2) LLM에서 포착된 학습 능력의 추가 신호를 정규화하여 대리 모델과 LLM 간의 격차를 완화합니다. 더욱이, 단순히 전체 점수가 높은 샘플을 선택하는 것은 3.3장에서 논의된 바와 같이, 뚜렷한 사용자 행동과 항목 지식("Greedy"의 성능 저하)의 학습을 약화시킬 수 있습니다.

4.3.2 다양한 대리 모델(RQ2)에 대한 견고성. 다양한 대리 모델에서 DALERec의 일반화 능력을 추가로 평가하기 위해, 우리는 각각 BERT4Rec [41], SASRec [20], DCRec [51]이라는 세 가지 대표적인 순차 추천 모델을 대리 모델로 사용합니다. 표 4의 결과를 통해 다음과 같은 결과를 얻을 수 있습니다: 1) 세 가지 대리 모델을 사용한 DALERec은 완전한 미세 조정 하에서 BIGRec보다 일관되게 우수한 성능을 보입니다. 이는 서로 다른 대리 모델에서 DALERec의 강력한 견고성을 입증합니다. 2) 서로 다른 대리 모델은 정확도에 약간의 변동을 일으킵니다. 이는 모델 아키텍처마다 사용자 행동과 항목 지식을 다르게 표현하여 다양한 선택 샘플이 성능에 영향을 미칠 수 있기 때문에 합리적입니다. 3) SASRec은 훈련 시간 비용이 가장 적게 들고 세 가지 대리 모델 중 경쟁력 있는 성능을 달성합니다. 따라서 SASRec은 실제 배포 환경에서 DALERec을 위한 좋은 대리 모델 선택이 될 수 있습니다.

4.3.3 선택 비율 𝒓(RQ3)의 효과. 선택 비율 𝑟이 DALERec에 미치는 영향을 조사하기 위해, 우리는 비율 𝑟을 0.2%(128발)에서 4%(4096발)로 변경하고 그 결과를 그림 5에 제시합니다. 관찰된 바에 따르면: 1) 선택된 샘플의 수가 0.2%에서 1%로 증가함에 따라 추천 정확도가 급격히 향상되며, 이는 𝑟 = 1%일 때 전체 훈련을 능가합니다.

또한 선택 비율을 2%에서 4%로 지속적으로 증가시키면 추가 샘플의 이점이 점차 감소하고 정확도가 약간 향상되는 것만 관찰됩니다. 우리는 DALERec이 식별하려는 목표가 주로 대표적인 사용자 행동의 작은 하위 집합에 추천 데이터 간의 격차가 있다고 의심합니다. 2) 한편, 추가 샘플로 인해 LLM을 미세 조정하는 데 드는 시간 비용은 점차 증가하지만, 전체 훈련에 비해 비용 절감은 여전히 94% 이상에 달합니다. 3) 경험적으로 전체 미세 조정 및 저비용과 비슷한 성능을 달성하기 위해 𝑟 = 1%를 설정하는 것이 권장됩니다.

4.3.4 사용자 그룹 평가(RQ3). DALERec이 전반적으로 우수한 성능을 달성하는 방법을 연구하기 위해, 우리는 다양한 난이도의 사용자 시퀀스에 대해 DALERec을 테스트합니다. 구체적으로, 무작위로 선택된 소수 샷 샘플로 훈련된 모델을 통해 각 사용자 시퀀스의 손실을 계산한 다음, 손실 값이 작은 더 쉬운 샘플(그룹 1)부터 손실이 큰 더 어려운 샘플(그룹 3)까지 사용자를 세 그룹으로 나눕니다. DALERec과 Random on Games의 각 그룹 결과는 그림 6에 나와 있습니다. 우리는 1) 손실이 큰 사용자는 예측하기가 더 어렵기 때문에 DALERec과 Random의 성능이 그룹 1에서 그룹 3으로 점차 감소한다는 것을 알 수 있습니다.

그럼에도 불구하고, 2) DALERec은 각 그룹에서 Random보다 일관되게 우수한 성과를 보이며, 이는 전체 성과에 미치는 영향을 고려할 때 DALERec의 효과를 입증합니다.

4.3.5 정규화 강도 𝝀의 효과. DALERec의 𝜆을 0.1에서 2로 변경하고 그림 7과 같이 성능을 평가합니다.

그림에서 다음과 같은 사실을 알 수 있습니다: 1) 𝜆의 값을 점진적으로 증가시킴에 따라 전반적인 정확도 추세가 전반적으로 개선되는 것으로 관찰되었습니다. 이는 3.2장에서 논의한 바와 같이 대리 모델과 LLM 간의 격차로 인해 영향력 점수를 정규화하여 LLM의 학습 능력에 맞출 필요성이 강조되었기 때문입니다. 2) 그러나 맹목적으로 더 큰 람다를 추구하는 것이 반드시 유익한 것은 아닙니다. 대리 모델의 성능 중심 영향력 있는 샘플과 LLM의 어려운 샘플 사이의 균형을 신중하게 맞춰야 합니다.

4.3.5 정규화 강도 𝝀의 효과. DALERec의 𝜆을 0.1에서 2로 변경하고 그림 7과 같이 성능을 평가합니다.

그림에서 다음과 같은 사실을 알 수 있습니다: 1) 𝜆의 값을 점진적으로 증가시킴에 따라 전반적인 정확도 추세가 전반적으로 개선되는 것으로 관찰되었습니다. 이는 3.2장에서 논의한 바와 같이 대리 모델과 LLM 간의 격차로 인해 영향력 점수를 정규화하여 LLM의 학습 능력에 맞출 필요성이 강조되었기 때문입니다. 2) 그러나 맹목적으로 더 큰 람다를 추구하는 것이 반드시 유익한 것은 아닙니다. 대리 모델의 성능 중심 영향력 있는 샘플과 LLM의 어려운 샘플 사이의 균형을 신중하게 맞춰야 합니다.

[5. Related Work]

[5.1 LLM-based Recommendation]

추천을 위해 LLM을 활용하는 것은 최근 주목받고 있으며 [36, 52], 다양한 추천 작업에서 그 잠재력을 보여주고 있습니다 [4, 12, 27]. 일부 초기 연구들은 문맥 내 학습 능력을 통해 강력한 LLM의 추천 능력을 탐구합니다 [9, 42]. 그럼에도 불구하고, 도메인별 추천 데이터에 대한 추가적인 미세 조정 없이는 LLM의 성능이 제한됩니다 [4]. 추천을 위해 LLM의 잠재력을 최대한 활용하기 위해, 일련의 연구는 추천 작업에 맞춘 다양한 미세 조정 전략을 연구합니다 [12, 26, 31, 32, 53, 54].

그러나 LLM을 미세 조정하려면 광범위한 계산 자원과 시간 비용이 필요하므로 실제 응용 프로그램에 방해가 됩니다.

따라서 LLM 기반 추천 모델의 미세 조정 효율성을 높이는 것이 중요합니다. 본 연구에서는 효율적인 LLM 기반 추천을 위한 데이터 가지치기 작업을 제안하며, 이는 LLM의 소수 샷 미세 조정을 위한 대표 샘플을 식별하는 것을 목표로 합니다.

[5.2 Coreset Selection]

코어셋 선택은 전통적인 머신러닝과 딥러닝(47, 50) 모두에서 널리 연구되어 왔으며, 데이터 효율적인 학습(44), 신경 아키텍처 검색(40), 능동 학습(39)과 같은 많은 다운스트림 작업에 도움을 주고 있습니다. 이는 전체 데이터에서 작지만 대표적인 하위 집합을 선택하여 비교 가능한 모델 성능을 달성하는 것을 목표로 합니다. 이전 연구는 주로 두 그룹으로 나뉩니다: 1) 휴리스틱 방법 [7, 10, 44]은 일반적으로 어렵거나 다양한 샘플이 모델 학습에 유익하다고 가정합니다. 2) 최적화 기반 방법 [21, 25, 50]은 이중 수준 또는 이산 최적화 기법을 활용하여 경험적 위험을 최소화할 수 있는 데이터 하위 집합을 최적화합니다. 그러나 휴리스틱 방법은 선택된 샘플이 경험적 위험에 미치는 영향을 간과하기 때문에 최적이 아닐 수 있습니다. 그리고 최적화 기반 방법은 복잡한 최적화를 위한 번거로운 계산 때문에 LLM 기반 추천에는 적용되지 않습니다. 또한, 이전 방법들은 선택을 위해 일반적으로 전체 데이터에 대한 모델 학습에 의존하며, 이는 LLM 기반 추천(제2장 참조)에서는 실현 불가능합니다.

• 데이터 응축 [56]은 데이터 효율적인 학습을 달성하기 위한 또 다른 잠재적 솔루션입니다. 그러나 이는 우리가 제안한 데이터 가지치기 작업과는 본질적으로 다릅니다. 작지만 유익한 데이터셋 [55]을 합성하는 것을 목표로 하지만, 우리의 작업은 대표적인 기존 샘플을 식별하는 것을 목표로 합니다. 또한, 이전 연구는 주로 연속 데이터를 대상으로 수행되었으며, 이는 LLM 기반 추천 [48]에는 적용되지 않습니다. TF-DCON [49]은 최근 콘텐츠 기반 추천을 위해 제안되었으며, 우리는 이를 4.2절에서 비교합니다.

[6. Conclusion]

이 연구에서는 효율적인 LLM 기반 추천을 위한 데이터 가지치기 작업을 제안했습니다. 이 작업은 LLM의 몇 샷 미세 조정에 맞춘 대표적인 샘플을 식별하는 것을 목표로 합니다. 또한, 우리는 이 데이터 가지치기 작업을 위해 두 가지 목표를 제시했습니다: 1) 낮은 경험적 위험을 초래할 수 있는 샘플을 선택하기 위한 높은 정확도의 목표; 2) 데이터 가지치기 과정에서 낮은 비용을 소비하기 위해 높은 효율성을 위해 노력합니다. 이를 위해, 우리는 두 개의 점수로 영향력 있는 샘플을 효율적으로 식별하기 위한 새로운 데이터 가지치기 방법인 DALERec을 제안했습니다. 1) 영향력 점수는 영향 함수에서 확장되고 대칭 속성을 통해 가속화되는 샘플 제거가 경험적 위험에 미치는 영향을 추정하기 위해 공식화되었습니다. 2) 영향력 점수를 효율적으로 계산하기 위해 작은 크기의 대리 모델을 도입하고 대리 모델과 LLM 간의 격차를 해소하기 위해 노력 점수를 제안했습니다. 경험적 결과는 DALERec이 높은 효율성과 높은 정확성을 모두 달성하는 데 효과적임을 입증합니다.

이 연구는 LLM 미세 조정을 위한 데이터 가지치기 작업을 제안합니다. 이 작업은 효율적인 LLM 기반 추천을 위한 새로운 연구 방향을 열어주며, 향후 연구에 많은 유망한 방향을 남깁니다. 1) 더 많은 크로스 도메인 데이터셋에서 DALERec을 더 많은 LLM 기반 추천 모델에 적용하여 제한된 자원으로 미세 조정 성능을 향상시키는 것이 가치가 있습니다. 2) LLM의 제한된 컨텍스트 창 길이로 인해 사용자의 상호작용 시퀀스에서 유익한 상호작용 항목을 선택하여 LLM의 미세 조정을 수행하는 것이 유망합니다. 3) LLM 기반 추천 모델의 추론 효율성을 향상시키는 것은 실제 배포에서도 중요한 문제입니다.